Introduction

Ma vénérable machine fixe vient juste de prendre sa retraite, après 8 ans de loyaux services.

Dans ce post j'examine si l'upgrade vallait vraiment la peine étant donné que mon vieux Sandy Bridge overclocké comme l'enfer n'était pas très loin derrière les tous derniers CPUs Intel à SuperPI (lol).

J'en profite pour PASSER CHEZ AMD et radoter sur les "architectures modernes" et comment tout était plus simple avant, avec mes explications sur le chipset x570 et pourquoi ne pas choisir une carte mère Asus.

Sachant que le premier ordi que j'ai assemblé avait un Core 2 Duo avec deux coeurs (ben ouais), j'aurais jamais pensé que le futur ressemblerait à ça:

Le Ryzen 3900x s'avère être une chouette geekerie mais NONDIDJU que les choses se sont compliquées en 8 ans.

8 ans d'âge!

Aaaah ma vieille tour... Construite principalement pour me perdre dans Skyrim quelque part entre 6 mois et 1 an après sa sortie.

C'était l'époque du Sandy Bridge mais genre 1 mois avant la sortie d'Ivy Bridge parce qu'il y a toujours une nouvelle génération qui sort 1 mois après qu'on ait assemblé son nouveau jouet, c'est une règle majeure du jeu.

Le seul moyen de d'essayer de se libérer du cette destinée c'est acheter un CPU directement à sa sortie quand il est bien bien cher. Ou alors avoir de la chance parce que la concurrence d'AMD et le 5ème cycle de recyclage de la même architecture Intel a un résultat direct sur les prix de mise sur le marché.

Pour mieux vous imaginer l'odeur de vieux d'il y a 8 ans, les gens ils mettaient des graveurs DVD dans leurs tours. Je vous jure. C'était genre normal.

L'âge d'or de l'overclocking

Quand je parle d'âge d'or de l'overclocking, je veux dire qu'autour du Sandy Bridge, Intel avait l'habitude de lacher des processeurs qui fonctionnaient bien en dessous de leur potentiel, fréquence de "turbo boost" comprise.

C'était aussi vrai avant ça, puisque le vieux Core 2 Duo E6600 que j'avais avant s'overclockait très facilement à 2.66 Ghz sans devoir changer de voltage, c'est-à-dire qu'on obtient l'équivalent d'un E6700 pour moins cher et sans risques (c'est exactement les mêmes specs à part la fréquence).

On pourrait même voir ça dans l'optique que c'est une grosse arnaque d'acheter un E6700, voire même un E6800 (mais je pense qu'il a plus de cache celui-là, pour ce que ça vaut).

Aujourd'hui les algorithmes de boost sont non seulement bien plus complexes, mais vont bien plus loin (le i9 9900k peut booster à 5 GHZ sur un coeur dans certaines conditions — C'est 1.4 Ghz au dessus de sa freq annoncée!).

J'avais acheté un Core i7 3820, qui est en fait un SandyBridge-E (genre de Xeon repackagé), lequel avait des performances similaires au 2700k mais avec plus de cache, au prix de ne pas avoir tous les coefficients d'overclock déverouillés (puisqu'il n'a pas le k).

Fréquence de base: 3.6 Ghz, turbo: 3.8 Ghz.

Mais en fait... Mon CPU pouvait tourner à 4.2 Ghz avec un undervolting. Je précise que normalement quand on overclock il faut augmenter le voltage pour conserver la stabilité. Vous comprenez ce que je voulais dire quand je parlais d'âge d'or de l'overclocking?

J'imagine que l'absence de concurrence de l'époque avait pour résultat qu'Intel ne se fatiguait pas trop pour pousser leurs produits au maximum. Enfin, ça et les limites du silicium qui n'étaient pas encore atteinte à ce moment là non plus.

D'ailleurs, un peu plus tards ils allaient abandonner la soudure du bouclier thermique (la plaque métallique apparente sur le dessus des processeurs) au circuit sous-jacent et utiliser une vieille pâte thermique entre les deux, ce qui entraînera une grosse chute des possibilités d'overclocking des générations suivantes, à moins de démonter son CPU avec un marteau (autant dire que ça annule la garantie) avec un procédé appelé deliding.

C'était moins la classe.

Que je sache, c'est seulement récemment qu'Intel est revenu à la soudure. Sans doute à cause d'AMD et aussi probablement parce que leur plan commençait à juste beaucoup trop chauffer. Enfin je pense, c'est peut-être juste par générosité spontanée. Truc normal de capitalisme quoi.

Chipset X79

Une de mes raisons de choisir un i7 3820 plutôt que le plus-normal 2700k c'était le chipset X79.

Pour pas trop trop cher, il donnait accès à PCIe 3.0. Ce qui s'avérera être un excellent choix puisque PCIe 3.0 s'est généralisé assez vite après ça.

Par contre il n'avait pas d'USB 3 natif (POURQUOI) et donc ma carte mère avait l'équivalent d'une carte d'extension USB 3 en PCIe mais intégrée à la carte mère, avec 2 ports USB 3 seulement, tout le reste USB 2.

Dernière chose: SandyBridge-E et X79 permettent le quad-channel sur la mémoire. Un truc qui est rare à l'heure actuelle aussi (je pense que les Threadripper d'AMD peuvent utiliser du quad-channel) et permet d'avoir une bande passante mémoire gigantesque et totalement inutile. J'ai tout de même fini par remplir toutes mes 4 banques pour en "bénéficier". Je pense que ça change rien mais bon.

Les (vieilles) specs

| Boitier | LDLC Danube 2.0 (lol) |

|---|---|

| CPU | Intel Core i7 3820 |

| CM | ASrock X79 Extreme4 |

| RAM | 16 GB G.Skill Ripjaws DDR3 1600 Mhz CL9 |

| Cooler | Noctua NH-D14 |

| Alim | Corsair HX750 modulaire |

| Carte graphique | Radeon HD 7950 → Geforce GTX 980 Ti |

| Stockage | Curcial M4 250GB SATA SSD + 2xHDD 1500GB RAID 1 |

| Moniteur | Samsung 23'' LED quelconque, avec une bonne dose de ghosting |

| Souris | Logitech G9x → Logitech G502 |

| Clavier | Razer Blackwidow 1ère édition MX blue → Leopold FC500r blank MX brown → Ducky Shine 3 année du serpent MX brown |

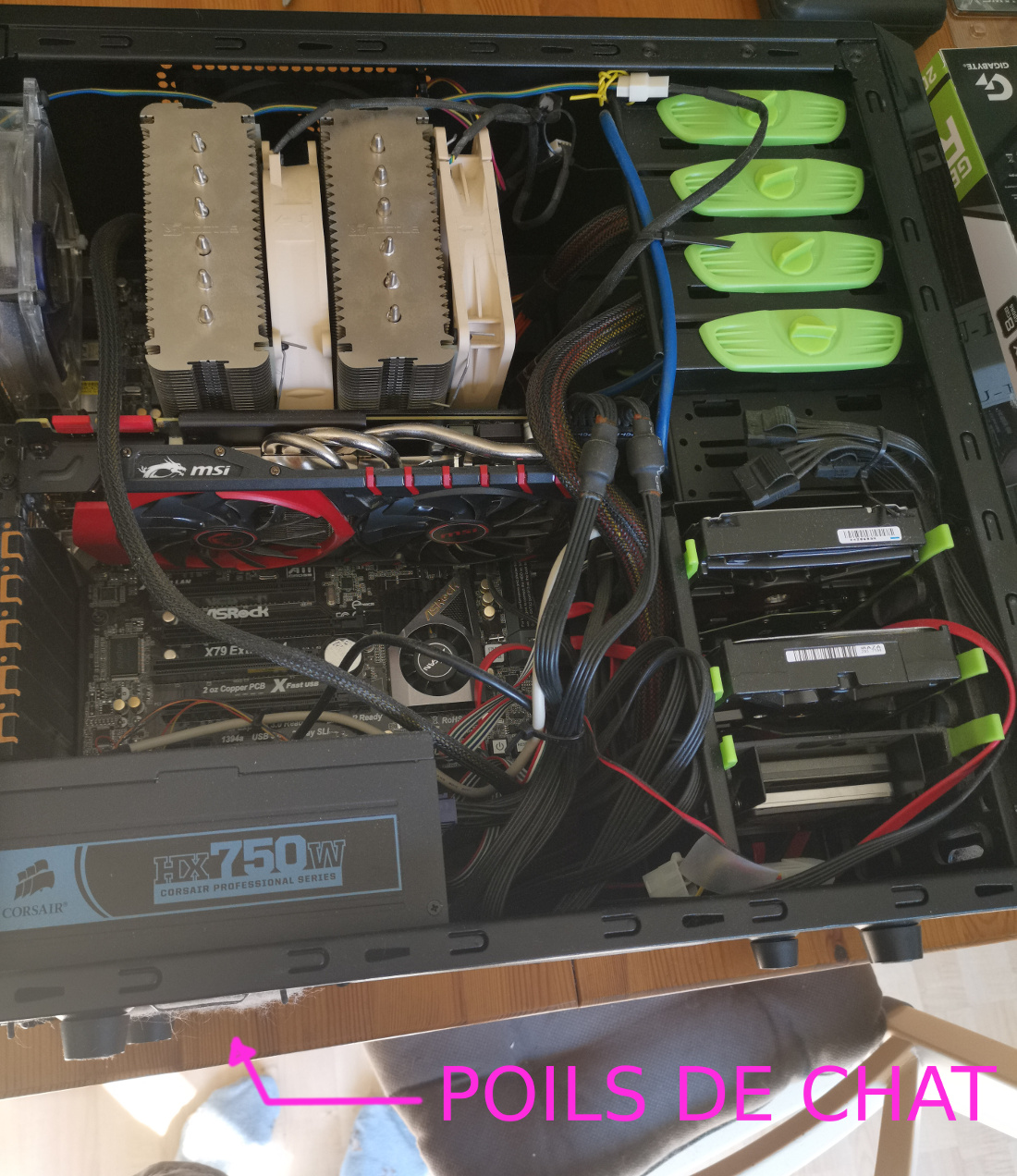

J'ai commencé avec un RAID 10 de disques durs comme stockage + un RAID 1 mais c'était la pire idée au monde et j'ai fini par acheter le SSD qui est dans les specs (j'ai gardé le RAID 1).

Déjà, on se dit, chouette, une alim modulaire ça fait moins de cable! Mais avec 1000 disques durs il faut tout plein de cables et en fait tout est branché sur l'alim modulaire et elle n'est plus modulaire du tout.

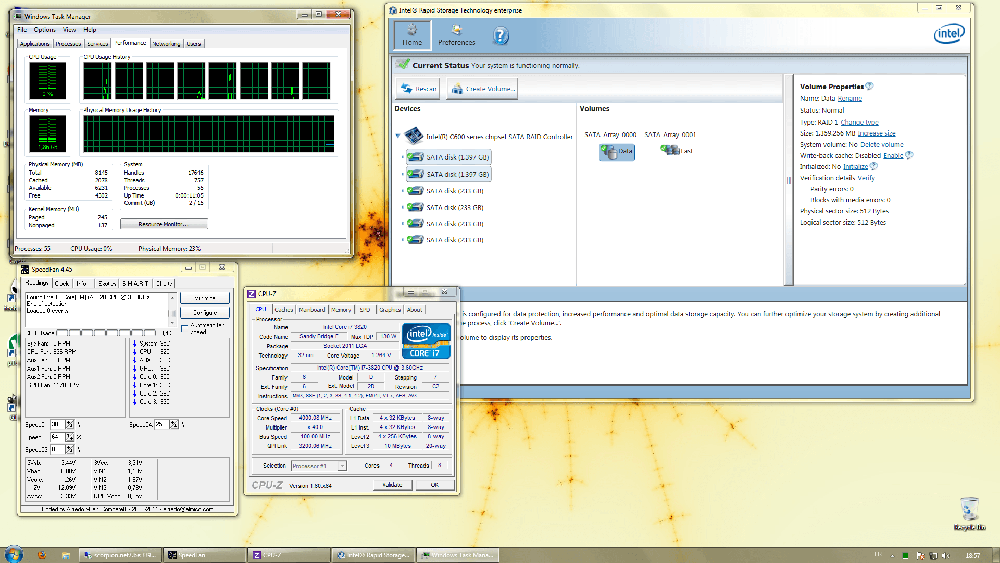

6 disques durs dans le gestionnaire infernal de RAID Intel (qui est horriblement lent, accessoirement):

J'aurais pu garder le Noctua et leur demander le kit de montage pour le nouveau build. Le ventirad est certes excellent mais un des ventilos commence à faire du bruit et ce truc est immense et super lourd, c'est impossible de chipoter dans le boitier pour rebrancher des ventilos etc. quand il est en place.

Le tout pour, à mon avis, un gain médiocre en température. En tous cas c'est ce que les tests ont l'air de dire quand il s'agit de comparer un Noctua NH-U12A au NH-D15 (2% mieux) qui est l'équivalent moderne du vieux D14.

La tour est extrêmement cheapos (50€ si je me souviens bien) mais avec tous les emplacements de ventilos que je voulais.

Le plus gros handicap de cette tour c'est la présence des emplacements pour lecteurs optiques, ça prend plein de place là où on installe les cartes graphiques et les câbles de la prise audio face avant passent par là aussi, en embarquant un bruit de fond parasite extrême. Bon, de toutes façons j'utilise une carte son USB alors prout.

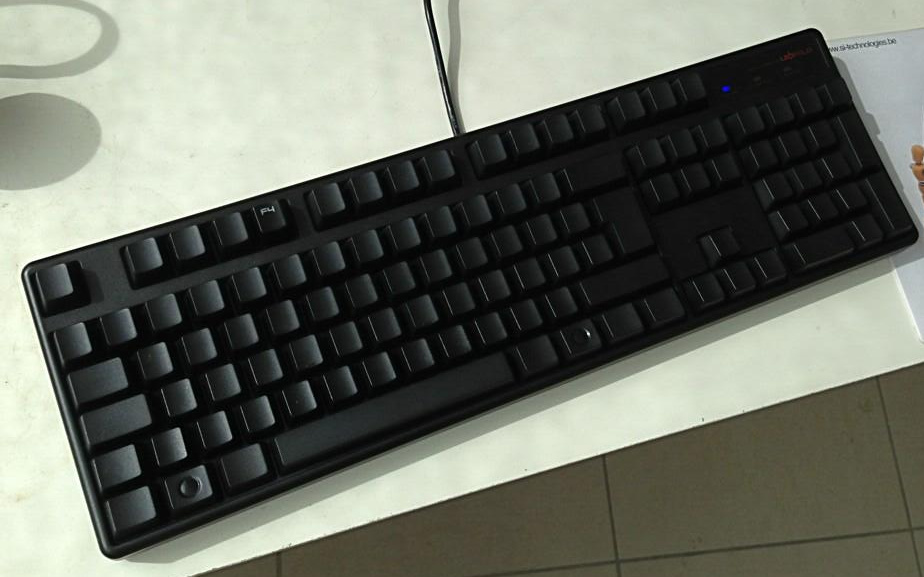

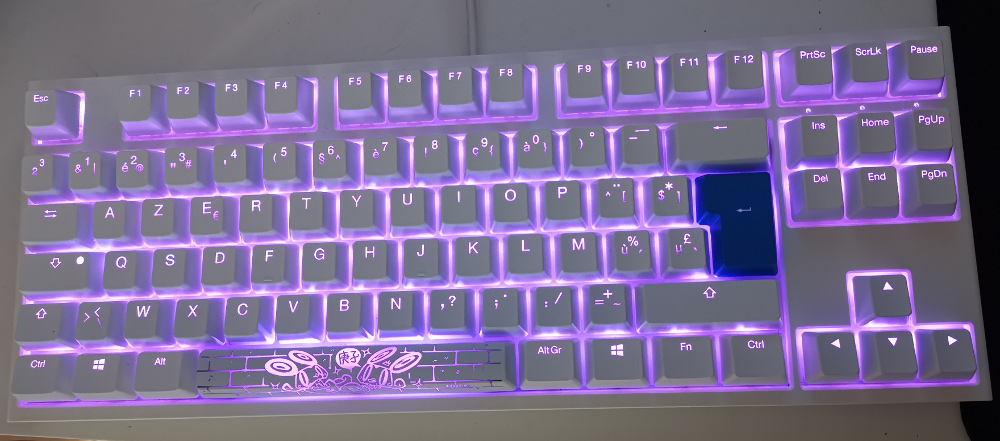

On voit aussi que j'ai beaucoup changé de clavier, le Blackwidow était charmant mais un peu moisi quand même (n'acceptait que deux touches en même temps, ce qui était moyen pour StarCraft) puis un jour il a eu un accident de bière sur le pavé numérique.

De plus, même si les MX bleus ont beaucoup de charme, je les trouve fatiguants si vous avez de longs trucs à taper (fatiguant à cause du bruit, je précise). Je suis passé aux marrons après (je fais trop d'erreurs sur les rouges et les noirs sont trop durs).

Le Leopold est vraiment excellent. J'avais entendu parler de cette marque Coréenne dans le monde StarCraft, sa construction est proche de celle des claviers Japonais Filco. Finition excellente, très reposant à utiliser.

A force de jouer dessus il a fini par contracter la maladie principale des claviers mécaniques: il écrit parfois deux fois la lettre "d" quand on tape dessus (je tourne beaucoup à droite dans les jeux).

Je l'ai remplacé par un Ducky Shine, avec DES LEDS ROSES. Excellent clavier aussi quoi que construit d'une manière tellement rigide qu'il est assez bruyant et fait des bruits de ressorts. Rien de très dérangeant pour jouer mais légèrement fatiguant pour coder et taper toute la journée (ce pourquoi j'utilise un Topre RealForce de toutes manières).

Ma vénérable G9x a fini par avoir la maladie des vieilles souris, qui est un peu similaire à la maladie des claviers mécaniques: elle enregistrait parfois deux clics plutôt qu'un seul.

Je faisais partie des gens tristes que Logitech ait décidé de ne plus construire cette souris, dont la dimension, le poid de base et la prise en main étaient excellents pour moi. Bon... La G502 est d'excellente qualité aussi, j'aurais juste aimé qu'elle soit moins épaisse.

Pourquoi l'avoir gardé aussi longtemps?

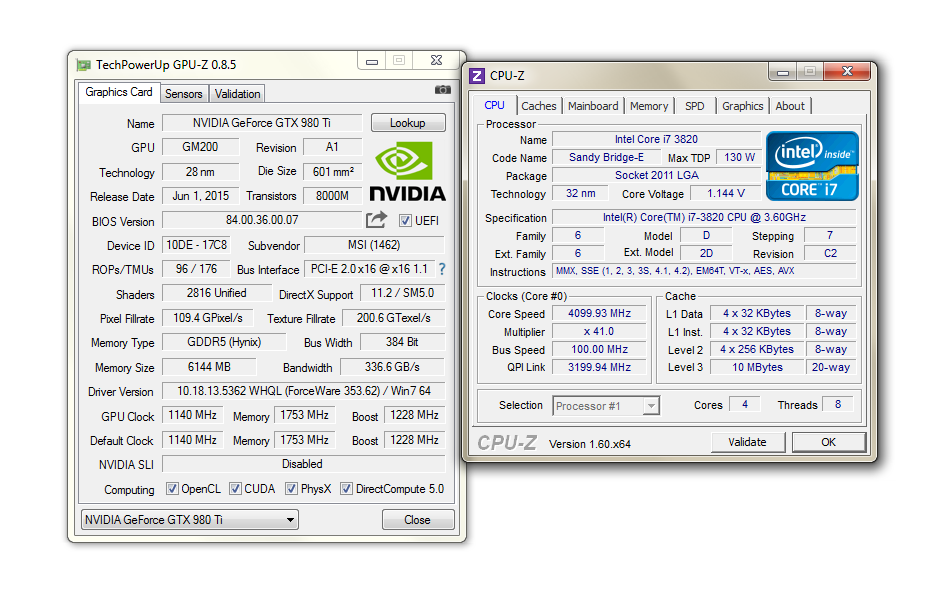

L'upgrade de carte graphique vers une 980 Ti est le truc le plus significatif qui soit arrivé à cet ordi. Cette carte est balaise, encore aujourd'hui.

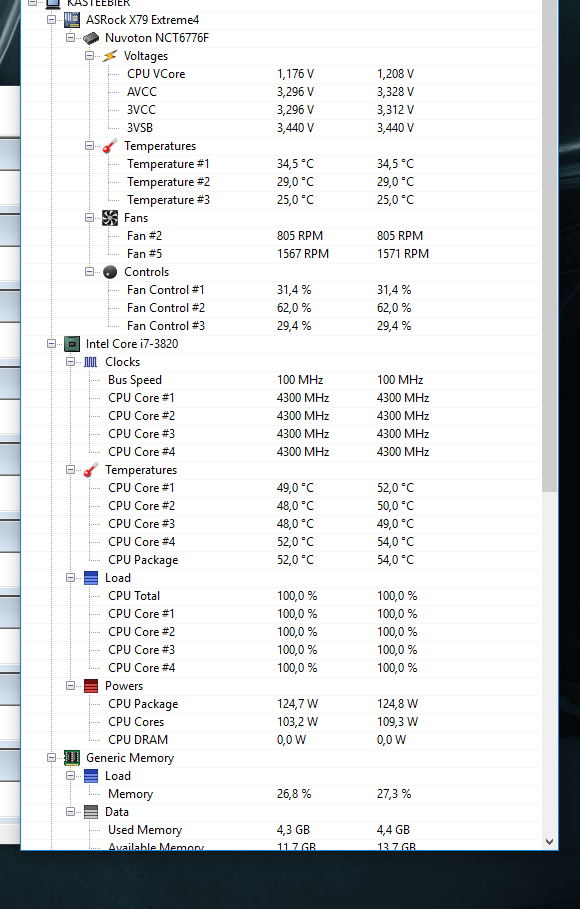

Ensuite il y a l'overclock. Ne pas avoir de coefficients débloqués est un petit peu embêtant puisque le max est alors de 4.3 Ghz, et si je me souviens bien, mon 3820 pouvait se prendre cet OC au voltage de base.

Ceci dit, même avec les coefficients débloqués, il aurait été nécessaire d'utiliser un LLC (Load Line Callibration) aggressif, presque certainement désactiver speedstep (déclocking en cas de basse charge) et peut-être même les C-states (voltages plus bas au repos).

Tout ça aurait significativement augmenté la consommation moyenne de la machine et de toutes manières, au vu des températures (le max est de 65° degrés seulement (et c'est pas pour rigoler il y a des écrans bleus autour de cette temp), mais la taille du CPU est massive donc ça se tient plus ou moins), je n'aurais proablement pas pu dépasser les 4.5 Ghz.

Au départ j'utilisais un seul OC à 4 Ghz au voltage de base (un OC au voltage de base est absolument sans aucun risque - à condition que les températures soient correctes mais sur un SandyBridge elles le sont largement). Puis je suis assez vite passé à 4.3 Ghz.

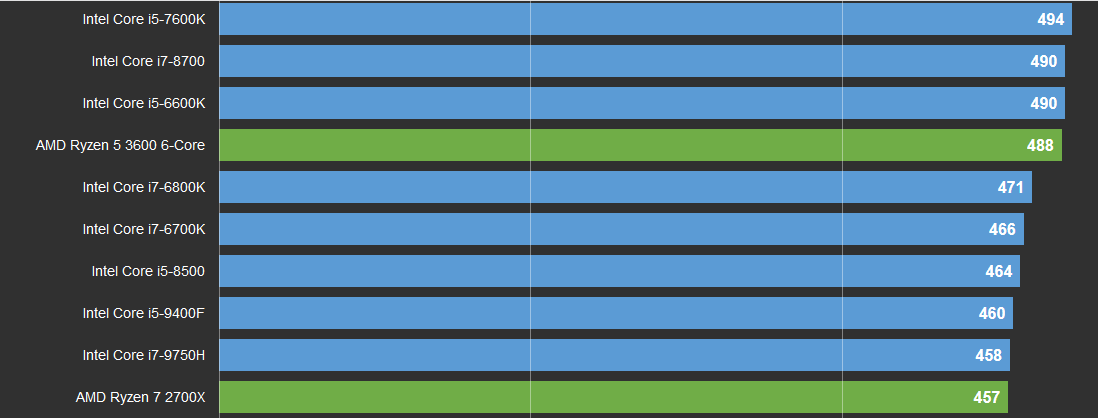

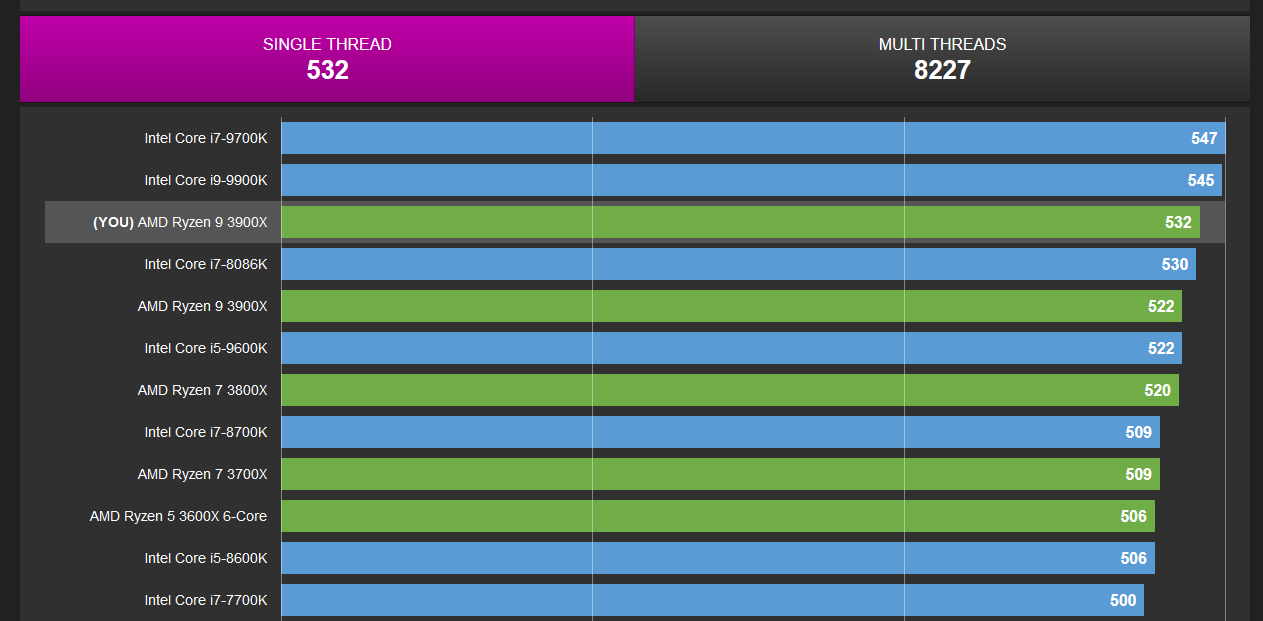

Comme je disais dans l'intro, cet OC me donne un score SuperPi 1M légèrement inférieur à celui de mon actuel Ryzen 3900x stock. En n'oubliant pas que SuperPi ne présente qu'une facette assez limitée de travail mono-thread.

D'ailleurs sur Cinebench R20 single-core l'i7 3820 0C à 4.3 Ghz n'a qu'un score de 307 contre 520 pour mon Ryzen 3900x. Il y a un écart similaire dans les tests Geekbench single core. Les tests multithreads c'est vraiment pas du jeu alors n'en parlons pas.

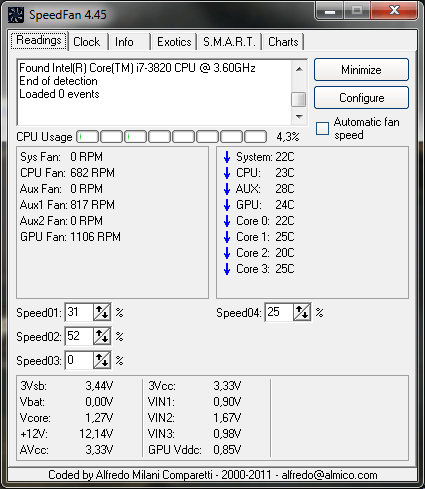

Les températures sont loin du max de 65° (qui est assez faible pour une température max, mais la puce 3820 a une grande surface) et ce sous Prime95, qui, j'explique au cas où, présente une situation de stress thermique qui n'existe pas en utilisation normale pour un CPU.

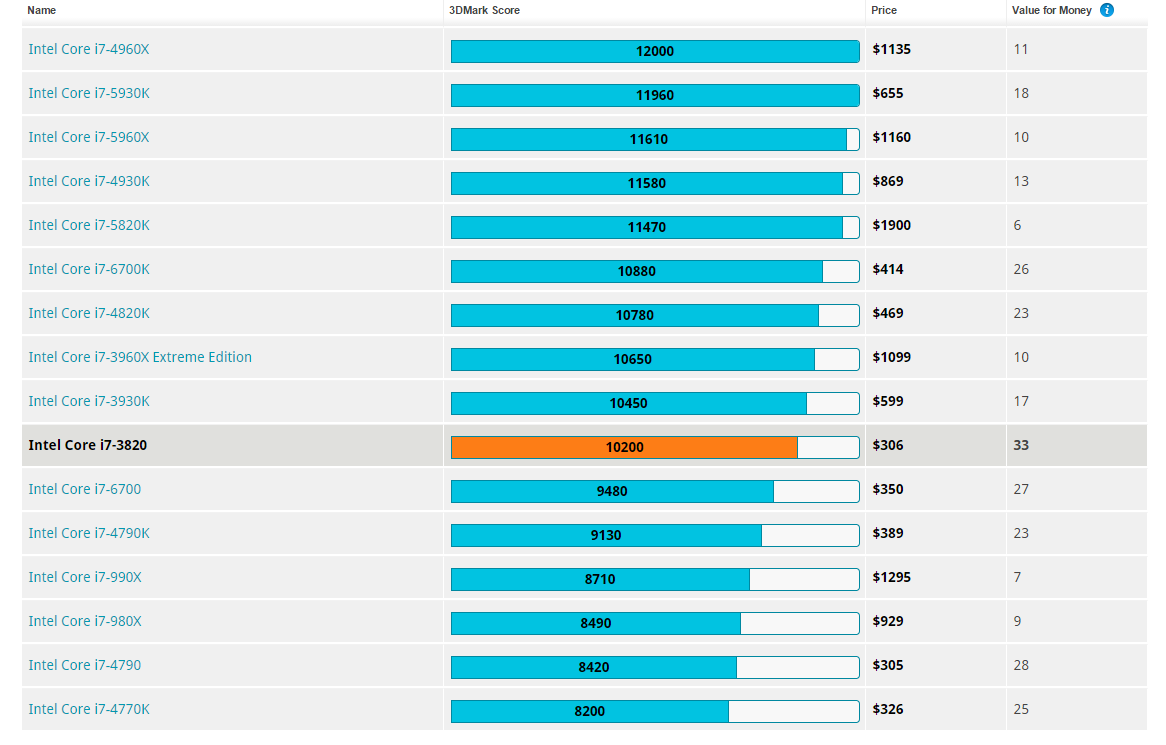

Les scores CPU de je-ne-sais-plus-quel test 3Dmark me claissaient très proche du i7 6700k qui est moulte générations plus récent et en plus est le pionnier de l'architecture (Skylake) qu'Intel utilise toujours aujourd'hui (non c'est pas une blague).

Notez que je suis aussi devant le 4790k qui était un champion de son époque avec une fréquence boost à 4.4 Ghz.

Il est néanmoins vaincu, à mon avis à cause d'un gag dans le fonctionnement du "turbo boost" en cela qu'il est limité dans le temps alors que mon 3820 est non-stop à 4.3 Ghz. J'imagine qu'un 4790k ou 6700k overclockés seraient plus significativement devant. Et j'ignore tout du potentiel d'OC de ces CPUs.

Toujours est-il que ça commence à sérieusement vieillir.

Récemment j'ai décidé de changer ma pâte thermique pour mettre du Thermal Grizzly. Et de fait, la réputation de ces pâtes thermiques est méritée, j'ai perdu environ 5° en moyenne (probablement plutôt 7)!

Ce qui m'a permis de tester un autre OC, qui deviendra l'overclock d'hiver avec une horloge de base modifiée pour passer à 4.4 Ghz. Trop tripoter l'horloge de base peut créer des instabilités au niveau PCIe et modifie également l'horloge de la RAM, du coup j'ai aussi dû OC ma RAM qui est moyennement faite pour.

Cet OC n'est que moyennement stable et plante régulièrement s'il y a plus de 30° de température ambiante. Ce qui arrive un moment ou l'autre pendant l'été en Belgique, je vous jure.

Du coup je faisais des écrans bleus pendant des parties d'Overwatch et c'était pas chouette.

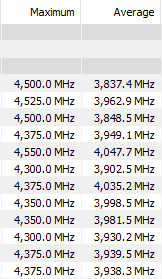

Une situation normale d'hiver c'est la tour autour de 20° et le CPU au repos autour de 25°:

Choix du nouveau CPU

Si c'est juste pour jouer le choix le plus intelligent serait entre un i7 9700k et un Ryzen 3700x. Le second étant environ €100 moins cher.

Mais j'ai pas attendu 8 ans pour faire un choix intelligent, ce sera un i9 9900k ou Ryzen 3900x, les deux sont quelque part autour de €500. Le 9900k est parfois toujours autour de €650 parce que sa baisse de prix (en réaction au 3900x qui est bien plus récent) n'est pas très très bien appliquée en Europe et on est punis comme ça.

Ceci dit il fut un temps où le i9 d'Intel était encore plus cher.

Au niveau des tests, faisons simple, en performance mono-coeur le 9900k est quelque part entre 5% et 12% plus efficace, en partie grâce à son boost mono-coeur possible à 5 Ghz.

Au niveau performance multi-coeur, le 9900k est 65% moins bien que le 3900x d'AMD (et je suis généreux). Ce pourcentage fait un peu mal au postérieur et est principalement dû aux 12 coeurs du 3900x (contre 8 pour l'Intel) et le boost d'AMD qui peut être soutenu raisonnablement sur tous les coeurs.

Je dois avouer que j'ai déjà bien envie de tenter l'aventure Ryzen. Creusons plus profondément dans mes raisons (lire: auto-justifications-pour-pas-être-déçu).

PCIe 4.0

Le seul moyen d'avoir du PCIe 4.0 actuellement est d'utiliser un Ryzen 3 avec un chipset x570.

Est-ce que ça sert à quelque chose? Non. La principale carte graphqiue PCIe 4 actuelle est la Radeon 5700 XT et j'avais décidé de ne plus acheter de carte graphique AMD (et en plus ça change quasi rien à ses perfs).

Cependant, je me souviens de mon choix foireux du chipset X79 pour l'ancien ordi et à quel point c'était judicieux de bénéficier du PCIe 3. Donc... Je me suis dit pareil. Si j'upgrade quelque chose ce sera probablement la carte graphique.

A ne pas oublier: les cartes mères x570 sont chères. Donc euh... Je sais pas trop si ça suffit à justifier le Ryzen.

Architecture et efficacité

C'est un point mineur mais Intel recycle l'architecture Skylake 14nm depuis 4 ou 5 générations en l'overclockant de plus en plus.

Même la prochaine génération qui inclut le futur 10900k utilise cette architecture.

C'est familier, on connaît bien, c'est sympa, mais la prise de risque est proche de 0 et ça fait pas avancer la technologie.

Tout ça on s'en fout en pratique sauf que ça a l'inconvénient que ces itérations de la même architecture de plus en plus overclockées consomment de plus en plus, à un point que ça en devient inquiétant.

Pour une raison obscure les Ryzen 3 consomment un peu plus que la concurrence au repos, mais en charge un i9 moderne peut dépasser les 200w alors qu'un 3900x en pleine charge sur 24 threads ne dépasse pas 140w.

En effet les Ryzen 3 utilisent un nouveau type d'architecture à base de "chiplets" qui sont des groupes de coeurs gravés en 7nm, le tout lié à une puce IO (ancien Northbridge) qui sert également de contrôleur mémoire, par un bus spécial qu'ils appellent l'infinity fabric (et qui par ailleurs augmente la latence mémoire, malheureusement).

Les chiplets 7nm sont petits, ce qui crée de gros points chauds de faible surface qui sont un peu embêtant à refroidir et empêche les Ryzen 3 d'être moins chauds que leurs équivalents Intel qui consomment pourtant significativement plus d'énergie en charge. Dommage. Mais en gros on en arrive aux mêmes besoins en refroidissement.

Toujours est-il que chez AMD, au moins, ils essayent des nouveaux trucs. Et leurs nouveau trucs sont étonnants d'efficacité tant en terme énergétique que de perf. par Ghz.

Prix

C'est surtout un problème d'Européen mais le Ryzen 3900x est moins cher que son concurrent. Voire beaucoup moins cher, 200€ d'écart chez certains vendeurs... A ce prix là il n'y a plus vraiment de compétition, le 9900k est écrasé.

Conclusion

La différence de perfs en jeux calculée dans les tests l'est toujours avec une 2080Ti. Avec une carte graphique inférieure, l'écart se rétrécit.

L'écart en perfs multicoeur est par contre plus que significatif. Et j'ose espérer que de plus en plus de jeux vont adapter des modèles multi-thread pour certains aspects (comme la gestion des foules) voire le moteur de rendu lui-même.

C'est impossible de dire si ce sera un bon choix par rapport à l'avenir, l'inverse est aussi possible, et les Ryzen 3 ne s'overclockent pas vraiment, ils sont déjà pratiquement à leur maximum avec leur politique de boost qui est assez complexe (discuté plus loin) alors que les CPUs d'Intel peuvent être OC, mais à un certain prix: leur consommation d'énergie devient rapidement brutale.

Si vous lisez cet article dans le futur, n'oubliez pas que les Ryzen 4 sont censés sortir quelque part vers septembre 2020 et à mon avis leurs prix resteront corrects même à la sortie. Du coup, si vous approchez de cette date, attendez!

Le chipset x570

Ce chipset qui permet de bénéficier en avant-première du PCIe 4.0 (entre autre (mineures) choses, hein) est un gros farceur.

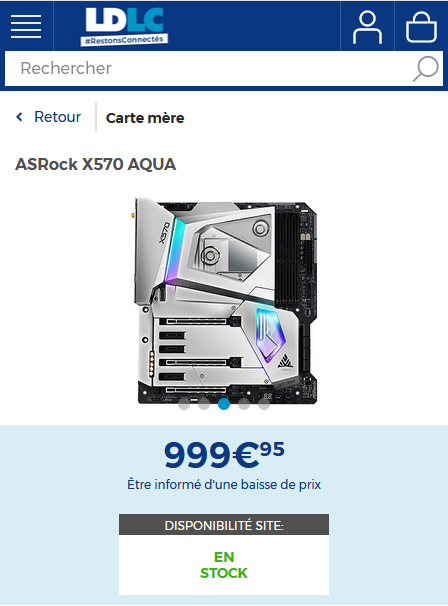

Déjà, il est cher.

J'ai toujours été adepte de prendre des cartes-mères milieu de gamme, ce qui pour moi est quelque part entre 100 et 150€.

Pas besoin de gros refroidisseurs VRM (régulateur de tension CPU) qui ressemblent à un vaisseau spatial et autres branding GaM3r avec des LEDs partout.

Du coup, je vois une MSI x570-A Pro et je me dis que c'est cool. A 195€ ça doit être du haut de gamme. Hein?

Ben non.

J'étais plus ou moins au courant de l'obsession pour les "GOOD VRMs" qui trainait depuis un peu de temps, en me disant que c'était lié aux consommations de malade des Intel xxxLake 12ème édition.

Et c'est en partie dû à ça, mais apparemment il y a aussi de vraies sales économies qui sont faites sur le régulateur de tension pour certaines CM.

Je poste pas l'image parce que c'est pas à moi, mais si vous regardez ici, sous 125w de conso CPU, vous voyez cette bonne vielle MSI x570 Pro avec un régulateur de tension à 96°.

Un VRM à 70° sous plus de 120w ça m'étonne pas vraiment, mais là on est à 37% de plus... Je veux bien qu'un VRM de moins bonne qualité consomme plus et chauffe plus mais pas à ce point là.

j'ai lu des histoires comme quoi l'auto-OC des Ryzen qui consomment le plus (dont le 3900x) pouvait être limité par la température du régulateur de tension.

Du coup j'ai eu peur et j'ai demandé un remboursement pour cette carte mère et j'en ai commandé une autre dans les 300€. Tant qu'à faire autant prendre le wifi, ça peut toujours servir.

En résumé, une carte mère x570 milieu de gamme, c'est au moins €250 en fait. Mince... Si j'avais su ça avant, mes décisions auraient peut-être été différentes.

Quoi que, les CPU Intel consomment tellement qu'ils ont besoin d'un bon régulateur et d'une carte-mère autour de 200€ minimum et il semblerait que les CM de la future génération Intel seront au moins aussi chères que les x570. On en est là maintenant.

Pour ce qui est des VRM, des gens ont compilé un Google Sheet avec le type de VRM utilisé et un appréciation.

En me basant là dessus, j'ai regardé la marque qui avait le plus de vert, et c'est Asus, et j'avais dit que je prendrais plus Asus parce qu'ils ont un site bizarre et des programmes moisis et un bios à la traine, et je me suis totalement ignoré. A cause de la quantité de VERT.

PROUT

Du coup j'ai prix une Asus ROG Strix x570-E Gaming, avec wifi, deux ports M.2 et euh... Un bon régulateur de tension n'est-ce pas.

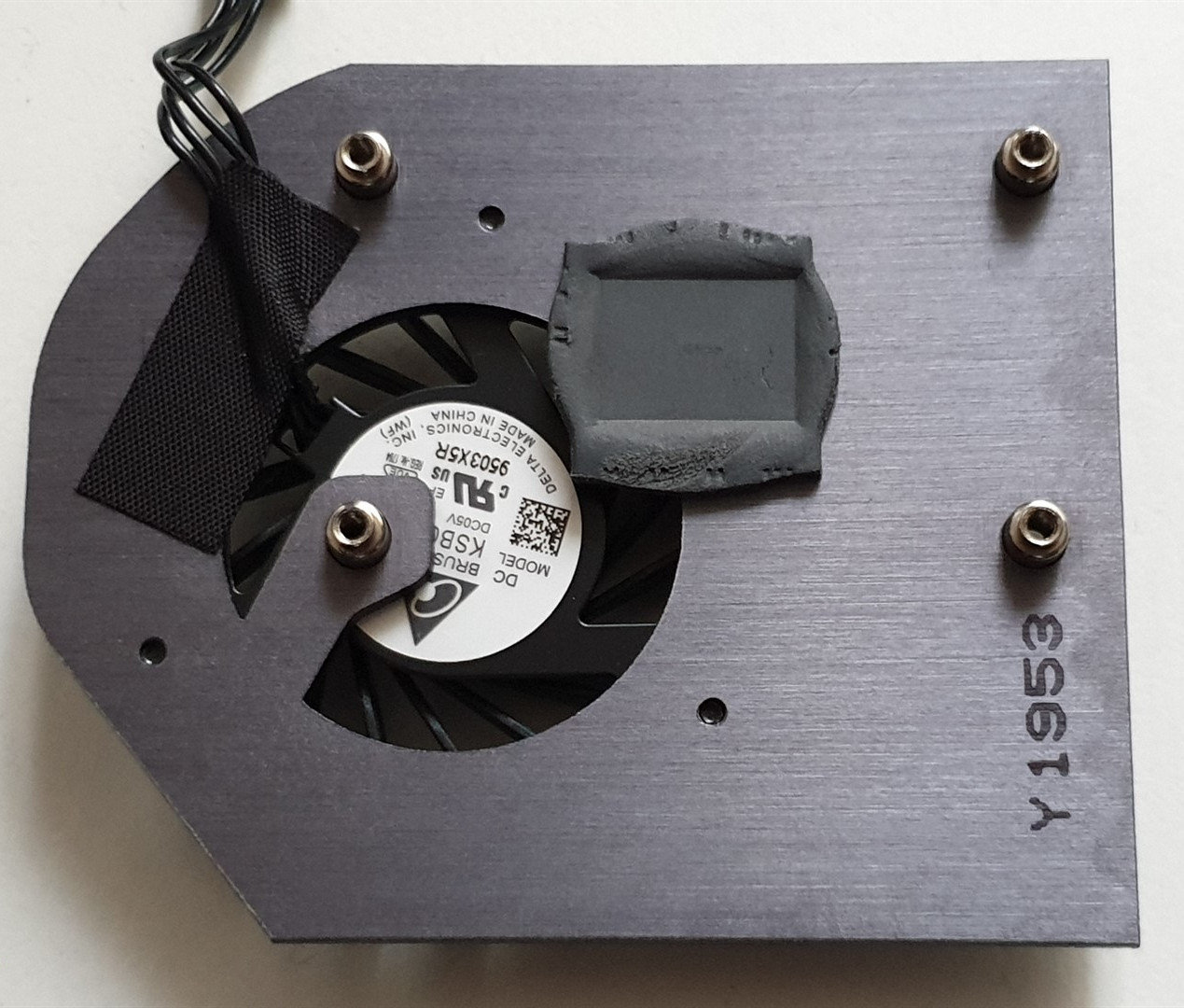

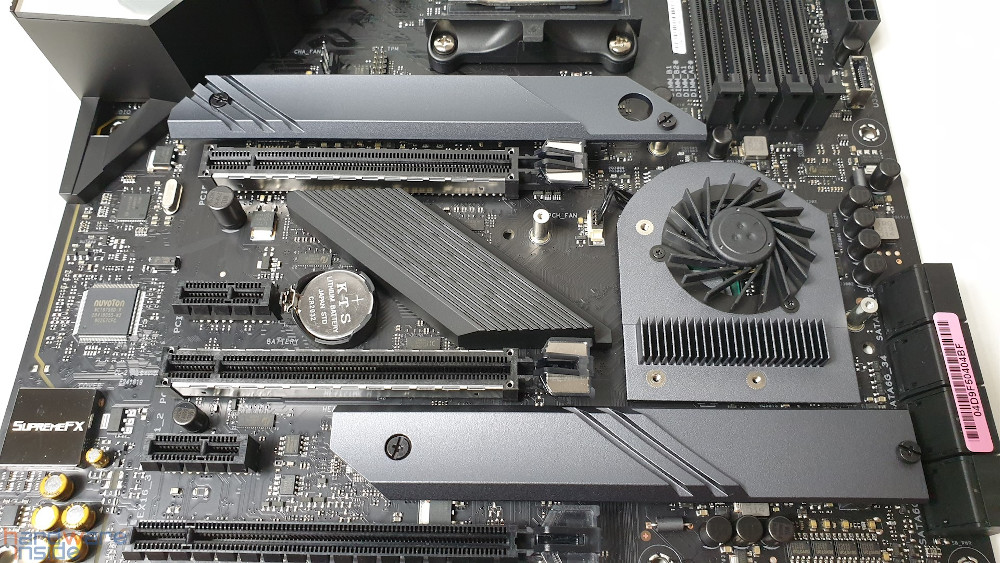

Il s'avère que le chipset x570 chauffe. Fort. Malgré une température max a plus de 95° il chauffe facilement à plus de 60. Au repos.

Au vu des températures, x570 a signé le retour des bon vieux ventilateurs de chipset, qui sont universellement pas trop trop appréciés. En fait, ma vieille CM X79 en avait un aussi. J'ai jamais trop compris pourquoi vu que le chipset restait autour de 40°, mais 8 ans après le ventilo tournait toujours (quoi que extrêmement bruyant à grande vitesse lors de certains tests quand le système boot).

Les seuls CM qui n'ont pas de ventilo chipset sont les plus haut de gamme. En particulier la Aorus Extreme de Gigabyte.

Tant que j'y pense... C'est possible que ça soit la seule (mis à part l'étrange ASRock avec ports watercooling à plus de €800).

Evidemment les fabriquants de carte-mère (à €300 dois-je-le-rappeler) ils collent juste un vieux pad thermique de qualité de merde puis un "dissipateur" qui est surtout en plastique, et, dans le cas de la carte que j'ai choisie ne couvre même pas tout à fait le chipset, parce que pourquoi pas hein. C'est peut-être fait exprès, qui sait.

Voyez vous mêmes sur ces photos qui sont pas à moi (source):

Le tout est couvert d'une coque en plastique vissée qui doit également être retirée pour installer les SSD M.2. La coque a des petits trous pour l'aspiration du ventilo, qui tombent évidemment juste en dessous du radiateur de mon énorme RTX 2070 Super qui est un modèle tri-ventilo particulièrement long.

Certaines cartes mères sont indulgentes avec le second port PCIe mais avec mon Asus, le second est en x8... Avec une carte graphique PCIe 4 ça aurait pu le faire.

Toujours est-il qu'en jeu, avec la coque, j'ai le chipset à 72° avec son ventilo qui tourne à 3000 RPM.

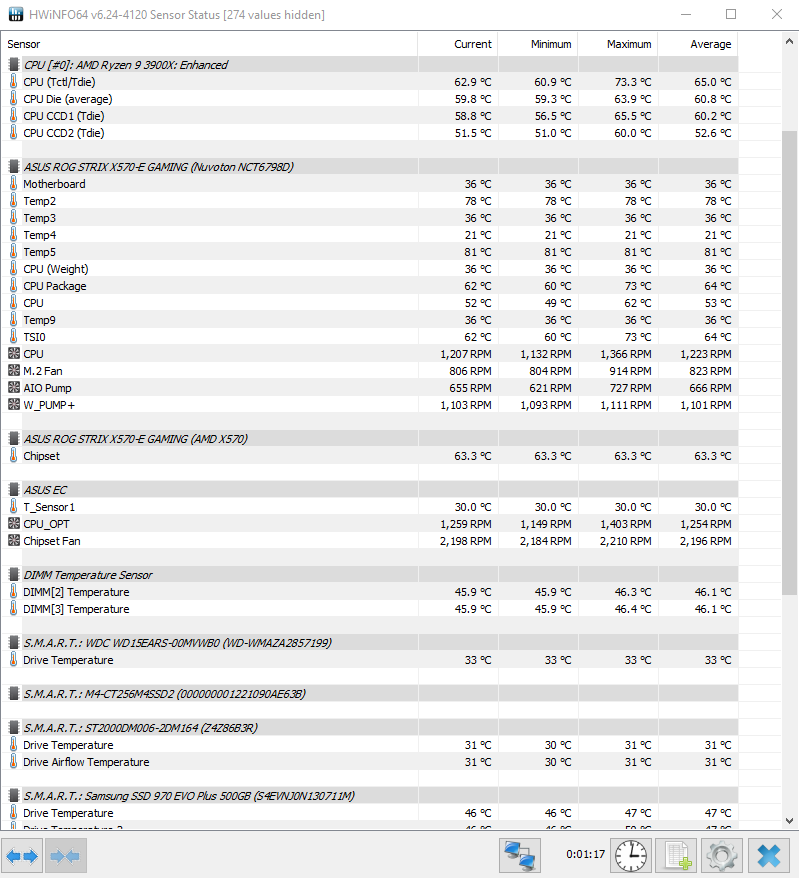

Vous savez quoi? Sans la coque ça descend à 62°, ventilo autour des 2200 RPM. Ici après 3 heures d'Overwatch (qui stress mon GPU au delà de 90% et donc chauffe significativement toute la tour):

Les capteurs qui sont autour de 80° je sais pas ce que c'est, il n'y a rien à ce genre de températures sur la carte mère (j'ai un thermomère infrarouge) et la Strix x570-E n'a pas de capteurs de température sur le régulateur de tension, parce que bien sûr. Donc c'est pas ça non plus. Et ça pourrait pas être ça, Overwatch est loin de pomper 140w de CPU.

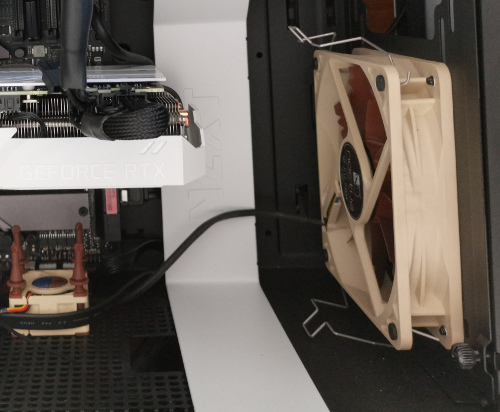

Pour revenir au chipset, j'ai aussi testé en faisant souffler un ventilo droit dessus, on perd encore 10°, ce qui m'a décidé à installer un ventilo de boitier, un des Noctuas du DH-14 que j'ai récupéré, d'où les machoires moches en metal.

J'ai gardé ce setup parce qu'il semble me faire gagner un petit peu de température CPU aussi et n'a pas d'effet évident sur la carte graphique. J'ai lu des témoignages de gens pour qui les témpératures étaient pires avec un ventilo en aspiration façade sur cette tour (Nzxt H510) mais heureusement ça n'a pas l'air d'être mon cas.

Comme vous pouvez le constater sur l'image j'ai aussi tenté un plan diabolique à base d'un tout petit ventilo Noctua mais il semble empirer mes températures chipset. Probablement parce qu'il ne souffle pas directement dessus.

Personne peut comprendre les mystères de la mécanique des fluides. Même les vrais scientifiques ils doivent utiliser des fumées colorantes ou une soufflerie.

Le mieux pour le chipset ce serait d'avoir un emplacement pour un ventilo de côté, mais cette tour a une grosse plaque en verre à la place, parce qu'aujourd'hui toutes les tours doivent avoir des grosses plaques en verre parce que les gens veulent des LEDs RGB sur leurs barettes de RAM. Okay. BEN MOI J'AI DES VENTILOS BEIGES ET BRUNS.

Sur mon ancienne tour j'avais un emplacement de côté que j'ai brièvement utilisé, mais ça prenait trop la poussière.

En soi, j'ai encore une fois pu vérifier que mettre des ventilos en entrée est relativement peu utile pour ce qui est de la carte graphique et du CPU. Par contre ça aide pour les autres composants (RAM et systèmes de stockage en particulier — Le SSD M.2 dans mon cas (les disques durs sont encore en dessous)).

Conclusion

Si vous voulez absolument une carte-mère x570, regardez la tronche du système de refroidissement chipset d'abord, en plus de la qualité du régulateur de tension.

Vérifiez aussi où il est placé. Les cartes MSI ont tendance à mettre le ventilateur chipset plus bas, ce qui est mieux si vous avez une grosse carte graphique. Par contre les MSI bon marché ont les pires régulateurs de tension, donc bonne chance.

Prenez une Gigabyte.

C'est pas mal de surveiller la température chipset et si son ventilo tourne toujours de temps en temps. Je vais peut-être me créer un genre de script de monitoring pour ça au démarrage de ma machine.

Ah oui et j'ai ce logo hyper sérieux qui apparaît quand je démarre à la place du logo Windows:

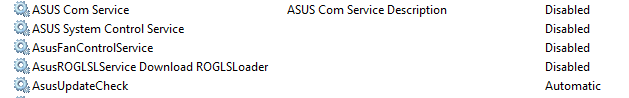

En bonus, on découvre plus tard avec joie qu'il y a 5 ou 6 services Asus qui traînent dans Windows et que je me suis hâté de désactiver.

J'ai aussi cette option BIOS étrange, est-ce que ça hack Windows pour qu'il télécharge ce process ARMOURY CRATE qui réapparaît tous les X temps? Maintenant en plus de désactiver les trucs chiants sous Windows, il faut aussi le faire dans le BIOS?

Quelle belle époque.

Journal de montage

Je m'étais mis très fort en tête de récupérer mon ancienne alimentation. En cherchant par-ci par-là il semblait que les Corsair HX étaient garanties 10 ans, donc il lui reste encore au moins 2 ans, probablement plus étant donné que mon ordi fixe ne tourne pas non-stop et en pratique il n'est pas allumé aussi souvent qu'on pourrait le croire parce que je suis vieux maintenant et je joue moins qu'avant.

Il s'avérera qu'en fait ce sont les nouvelles HX qui sont garanties 10 ans. La mienne c'était 5. Et en cherchant des histoires de catastrophes d'alim sur Twitter avant de dormir (une occupation classique pour moi) j'ai vu des défaillances après 10 et 12 ans, qui normalement n'impactent pas d'autres composants sauf que certains témoignages parlaient également de cartes-mère grillées.

J'ai eu un peu peur et j'ai racheté une Corsair HX750 modèle moderne, 80+ Platinum. Je dois dire que j'entends jamais son ventilo tourner.

Mais ça, c'était après. J'ai commencé par récupérer ma vielle alim et l'installer dans la nouvelle tour.

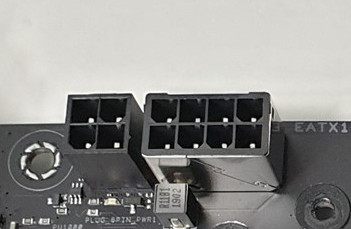

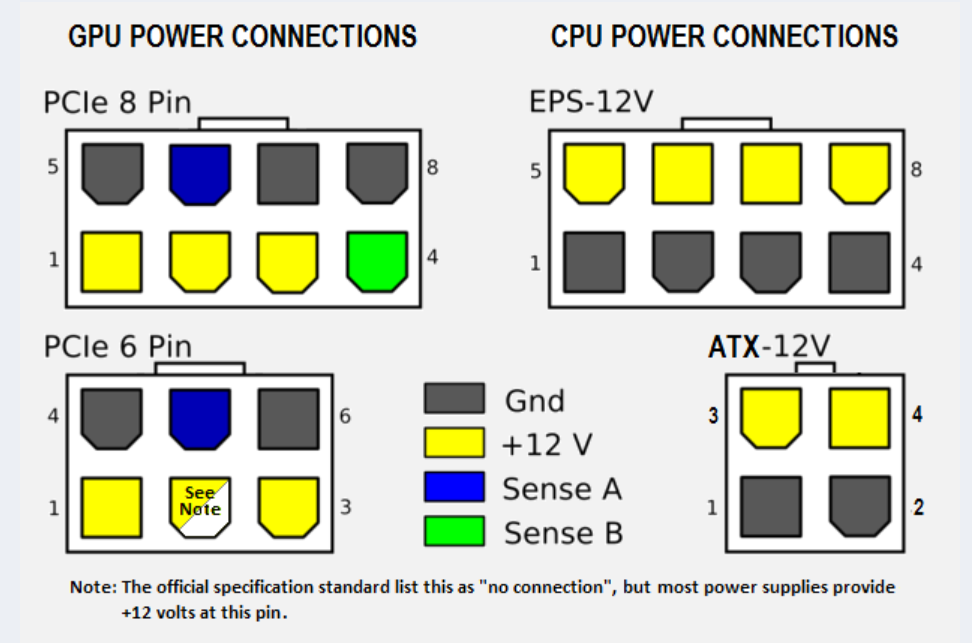

Viens ensuite la préparation des passages de cables d'alimentation de la carte-mère et celui de l'alimentation CPU. Et là, première farce... Il y a une prise en plus de la fiche 8 connecteurs que mon alim propose:

Je me suis dit, c'est pas grave ça doit être compatible avec une partie d'une prise PCIe. Logique non? Ben non pas du tout. Les voltages sont inversés, même. Parce que sinon c'est pas drôle:

Ce qui m'aura permis de tester les protections d'inversion de voltage de la carte mère (ou de l'alim je sais pas trop) puisque ça ne démarre pas avec une prise PCIe là dedans. Heureusement qu'ils ont pensé aux bétises que j'allais faire.

Il s'avère que la prise 8 pins seule peut fournir plus de 200w et le Ryzen 3900x non-overclocké ne dépasse pas les 140w. Donc en fait c'est tout bon. Mais moi ça me frustre d'avoir un truc pas branché.

En plus, brancher ce truc quand le ventirad CPU n'est pas encore en place, c'est déjà pas simple, mais avec le ventirad présent il faut des doigts bioniques.

Premier plan foireux: sortir le fer à souder et essayer de fabriquer une prise ATX 12v à partir de la prise PCIe. Il suffit plus ou moins d'inverser les phases, si le dessin posté plus haut est correct.

Résultat au multimère: une des phases est correcte, une autre est toujours inversée (???), et une des masses ne fonctionne pas du tout (probablement dû à mon travail dégeulasse de soudure).

Bon... Ben c'est pas grave après avoir passé une heure à chercher dans tous les Amazon d'Europe j'ai fini par trouver un adaptateur PCIe → ATX 12v à 7€. Je commande et branche juste les 8 pins pour l'instant.

Résultat final:

Le second montage

Je l'ai spoil dans la section précédente: j'ai psychoté à mort sur le fait que mon alim n'était en fait garantie que 5 ans et que les MTTF (MEAN TIME TO FAILURE) sont autour des 10 ans d'utilisation (utilisation non-stop ceci dit).

Finalement j'ai racheté une alim Corsair HX750 Platinum. Et j'en suis très content. Les alims LDLC sont plutôt chouettes aussi, elles sont en fait au même prix que les Seasonic platinum "entrée de gamme". Les Seasonic platinum haut de gamme étant un peu plus chères que la Corsair HX qui d'après les reviews était vraiment excellente.

Reste plus qu'à tout débrancher et rebrancher.

Ah merde et ma commande de cable de conversion PCIe/ATX elle en est où? Vite j'annule. Amazon me dit qu'ils me remboursent et que je peux garder le bidule. Effectivement il est dans ma boîte aux lettres. Bon, ben j'ai gagné un cable inutile gratuit. Chouette.

J'en ai profité pour commander un ventilo 140mm plus silencieux pour le dessus du boitier et un petit Noctua pour une autre expérience foireuse. Finalement je l'ai gardé débranché, mais il pourrait servir un jour pour refroidir le chipset, j'ai déjà plusieurs idées de montages.

Plus tard pendant les grandes chaleur j'ai acheté tout un tas de ventilos Noctua et je me suis rendu compte que le petit trou dans le bas de la tour c'est pour faire passer les cables d'alim PCIe pour la carte graphique, mieux vaut tard que dans encore 5 à 8 ans.

Les nouvelles specs

Je récupère la carte son USB, souris, SSD SATA et deux disques durs de l'ancien ordi.

| Boitier | NZXT H510 |

|---|---|

| CPU | AMD Ryzen 9 3900x |

| CM | Asus ROG Strix X570-E |

| RAM | 16GB G.Skill Ripjaws DDR4 3600 Mhz CL16 -> 32GB |

| Cooler | Noctua NH-U12A |

| Alim | Corsair HX750 modulaire 80Plus Platinum |

| Carte graphique | Gigabyte GeForce RTX 2070 Super Gaming OC |

| Stockage | Samsung 970 EVO Plus 500GB M.2 Crucial M4 250GB SATA SSD 2xHDD 1500GB |

| Moniteur | Acer ED242QR 23.6'' 144hz/1080p |

| Souris | Logitech G502 |

| Clavier | Ducky One 2 RGB MX Brown |

| Carte son | Prodipe Studio 22 Pro USB |

| Micro | Shure SM58 |

| Casque | Sennheiser HD 598SE (ouvert) |

Et oui, aussi, j'ai re-changé de clavier.

Le ventilo Nzxt qui reste est légèrement bruyant mais rien de très dérangeant. En règle générale il faut bien s'arranger pour ne pas mettre les ventilos qui n'ont que 3 pins en PWM (les laisser/mettre en "DC" (courant continu normal)) parce que sinon vous avez pas mal de chance que ça vibre comme l'enfer.

Le Noctua CPU en courbe silencieuse est pratiquement inaudible au repos. Je m'y attendais mais c'est de la super qualité de la part de Noctua. En même temps c'est pas bon marché non plus.

On se fait un petit bench CPU-Z vite fait pour essayer de se rassurer de pas trop regretter son choix d'avoir nié Intel:

Je ne montre que le single-core parce que le score multithread du Ryzen 3900x EXPLOSE l'Intel i9 9900k (et probablement aussi la prochaine génération d'Intel) mais ça on le savait déjà.

Si je veux me comparer à l'i7 6700k en single-core, il est quelque part dans les 471 points comme on le voit dans cet autre morceau du classement:

Difficile de dire où mon vieux 3820 OC serait mais à mon avis l'âge de l'architecture est un gros handicap dans ces benchmarks moderns qui montrent qu'avoir un bon score SuperPI ne fait pas tout.

NB: En fait j'ai dû renvoyer ce 3900X chez AMD, il générait des erreurs de parité dans son cache CPU (erreurs WHEA qui apparaissent dans les journaux système de Windows), ce qui n'est jamais censé arriver. Chacune de ces erreurs générait une interruption système qui affectait mes scores de bench. En véritié, même un très haut volume d'interruptions ne dérange pas trop un gros 12 coeurs, mais le processeur de remplacement qu'ils m'ont envoyé est bien meilleur (chauffe moins aussi) — Je ferai peut-être un autre article sur cette expérience à l'occase.

Débutants s'abstenir

J'étais un peu étonné lors du premier démarrage, à l'heure d'installer un Windows 10 tout frais sur le SSD NVMe, parce que... PAS MOYEN.

Ma clé USB est totalement invisible. Le système arrive à démarrer sur mon SSD Crucial qui possède toujours l'install Windows de l'autre ordi ceci dit. J'ai pas essayé de passer l'écran de login mais ç'aurait été tripant que ça fonctionne sans problèmes.

Il est temps d'essayer de comprendre ce qu'Asus a essayé de faire avec leur bios infernal. Je savais que j'aurais juste du prendre une Gigabyte.

Il semblerait que le truc qui empêche de démarrer sur la clé USB c'est:

- J'ai oublié de brancher l'USB 3 face avant lol

- Il faut désactiver le SECURE BOOT mais pour ce faire il faut d'abord effacer le clés de secure boot enregistrées (???) et euh... Après on peut activer un boot soit disant "legacy" qui s'appelle CSM et honnêtement je me souviens plus exactement de ce que j'ai fait mais c'était bizarre.

Ensuite j'ai pu facilement démarrer en UEFI sur ma clé USB (que j'avais créée avec Rufus).

Ma RAM elle est pas à la bonne vitesse

Apparemment c'est normal, la carte-mère applique juste une horloge de 2133 Mhz quelque soit la mémoire puis lâche le micro.

Il s'agit donc obligatoirement de soit règler manuellement tous les timings voltages etc. Ou activer l'équivalent d'un profil XMP pour AMD qui est un truc qui s'appelle "D.O.C.P.".

Pour être honnête je pense qu'il fallait aussi faire ça à l'époque du SandyBridge, sauf que la différence de fréquence n'était pas si énorme.

Il y a un autre gag avec la RAM qui est rarement évoqué: le bus entre la puce IO des Ryzen 3 et ses "chiplets" (qui s'appelle Infinity Fabric) doit tourner à une certaine fréquence, qui est normalement 1800 Mhz.

Si la fréquence d'horloge d'infinity fabric n'est pas égale à la moitié de celle de la mémoire, la latence mémoire augmente. Enfin il paraît. Et elle est déjà pas terrible.

Je sais pas si c'est vrai et à partir de quand une mémoire ultra rapide finit par contrecarrer cet inconvénient, mais du coup sans le savoir j'ai acheté la DDR4 "la plus adaptée" (3600 Mhz).

Je voulais juste de la RAM pas trop chère qui soit CL16 ou plus bas. Et celle a 3200 était au même prix que celle à 3600.

Au final j'ai appris quelques trucs:

- Avoir au moins "2 rangs" de mémoire permet un gain non négligeable de latence sans devoir overclock la mémoire — Pour avoir deux rangs il faut soit 4 barettes de mémoire "simple rang", soit deux (ou plus en pratique) de "double rang".

- Les barettes de 8GB sont pratiquement toujours simple rang (surtout à 3200+), donc 4x8GB est bien double rang.

- Les barettes de 16GB ne sont pas toutes double rang... Donc là faut faire des recherches.

- Les barettes de 32GB sont toutes double rang (enfin, en 2021).

- Pas juste regarder la latence CAS (le CL16 par ex.) mais aussi le chiffre suivant (trcd) — Une barette qui a les mêmes deux premiers chiffres plutôt bas (par ex. 14-14 pour de la mémoire @3200) est potentiellement excellente et probablement équipée de puces Samsung B-die. Ceci dit le prix devrait être élevé aussi.

- C'est plus difficile d'overclock 4 barettes de mémoire que deux parce que la plupart des cartes mères utilisent un câblage où les traces sont plus longues pour accéder à deux des barettes En pratique on s'en fout sur Ryzen, sauf si vous avez un kit de Samsung B-die super cher.

Le "turbo boost" des Ryzen 3

Le boost des Ryzen est probablement le truc le plus complexe que j'aie vu de ma vie en lien avec un CPU.

Avant le boost c'était simple: en cas de charge au delà d'un certain seuil, tous les coeurs du CPU passent à +200 Mhz par ex. Puis voilà. C'est tout. On redescend après.

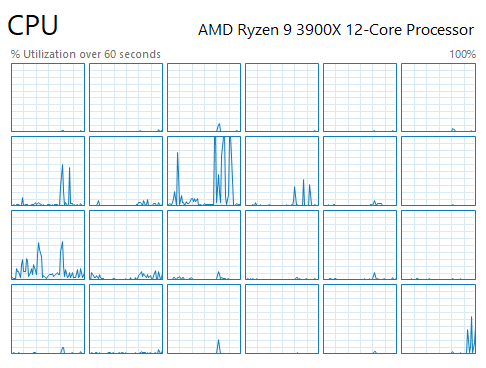

Sur les Ryzen 3 on passe d'un coeur à l'arrêt (oui ils peuvent se suspendre) à 800 Mhz, puis à 4300 Mhz, puis un micro-saut à 4550 Mhz puis retour à 2000 puis... Et sur un seul des 12 coeurs, les autres font leur propre salade de fréquences totalement indépendamment.

Le tout est contrôlé par rapport à la température du CPU, le courant engagé et la "puissance max en pic" par un genre de régulateur infernal qui est dans la puce IO sur le circuit du processeur.

En bref, c'est un truc de malade. Mais ça marche.

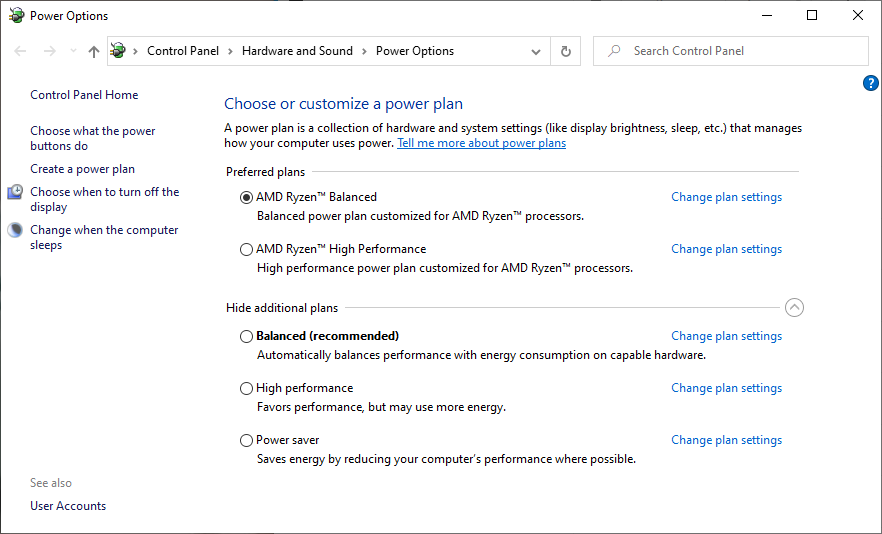

Par contre c'est tellement la folie qu'ils ont dû sortir un plan de gestion d'énergie Windows spécial Ryzen. Enfin, deux.

Ce qui est encore un autre aspect important à savoir: il faut absolument installer les drivers X570 téléchargés sur le site d'AMD.

Alors comment ça marche cette histoire de boost?

En gros, au plus il y a de threads qui tournent, au moins la vitesse est élevée. Si vos températures sont nulles, c'est encore pire. Si le voltage n'est pas assez élevé, le contrôleur ralentit la fréquence également.

Pour obtenir la fréquence de boost annoncée de 4.6 Ghz, il faut absolument qu'il n'y ait qu'un seul thread actif. Ce qui trouble beaucoup les gens parce qu'ils lancent un test mono-coeur et parfois ils ne voient pas la fréquence de 4.6 Ghz... Et c'est parce que Windows Update avait un plan en cours et qu'il a pas prévenu.

La complexité du boost des Ryzen 3 implique que les mises-à-jour BIOS sont importantes parce qu'il est possible de tout à coup optimiser toute cette soupe de fréquences et de voltages et de barrières de puissance et courants en tous genres.

Les voltages ont l'air élevés dis-donc là alors

C'est normal. En charge ils descendent tout seuls. La régulation du voltage de ce CPU est à l'image de la complexité de son système de boost.

Les Ryzen 3 sont extrêmement tolérants à l'undervolting, en cela qu'ils sont super durs à rendre instables par undervolting, ce qui est un peu suprenant.

Si leur voltage est trop bas ils s'engagent dans un plan que je comprends pas qui s'appellerait "clock stretching" et qui génère une importante perte de performance. Du coup je vous conseille pas d'appliquer une réduction de voltage trop élevée.

Beaucoup de gens, particulièrement sur le 3900x, appliquent un petit offset de voltage négatif. -0.5v est toujours OK avec normalement aucune dégradation de performances (parfois un gain, d'ailleurs) — A vérifier avec des benchmarks bien entendu.

Il y a beaucoup de croyances qui trainent sur une possible différence de température due à l'offset, en fait c'est peut-être juste un placébo.

La régulation interne de voltage fait que l'offset est normalement compensé par le CPU, à moins qu'il soit vraiment élevé.

Il semblerait qu'ils savent ce qu'ils font chez AMD et que les nouveaux Ryzen ont des couches d'oxides capables de résister aux 1.45V que l'on voit parfois appliqués à faible courant — En fait, le légendaire Buildzoid a tenté de dégrader un 3700x en le laissant à 110° et 1.45V pendant deux jours et il a a peine perdu quelques dizaines de Mhz d'overclock stable.

Le principal truc qui semble inquiéter la régulation interne des Ryzen en 7nm est la quantité de courant et il est de fait assez compliqué de les forcer à subir un courant plus élevé qu'un certain plafond préconfiguré.

Je précise au cas où pour les deux du fond mais le seul moyen d'avoir un courant élevé est de charger TOUS les coeurs à 100%.

Températures

La surface qui chauffe réellement ce sont les deux chiplets, et en particulier le meilleur des deux.

Par conséquent on se retrouve avec un gros point chaud qui n'est pas très grand par rapport à la surface du CPU:

Les chiplets sautent facilement de 10 ou 15° en très peu de temps. Ce qui veut dire que le temps que votre ventilo CPU réagisse, le pic est peut-être déjà passé.

Pour avoir les meilleurs réponses thermiques il faudrait avoir un programme pour souffler fort tout le temps... Ce qui est un peu triste au niveau du bruit.

Une demi-solution que j'utilise c'est d'appliquer un temps de "ramp-down" sur la descente de vitesse des ventilos. C'est-à-dire que si la température redescend au repos, je continue de souffler à la vitesse précédente pendant 12 secondes.

Comme il y a beaucoup de chances qu'un autre pic de température ait lieu s'il y en a eu un récemment, ça me semble être un bon plan.

Quoi qu'il en soit, je ne dépasse pas les 80° en pleine charge avec le Noctua (même sous Prime95).

Les Ryzen 3 peuvent monter jusqu'à 95° en théorie. Il me semble que c'est la même chose pour les CPUs Intel 9xxx.

Comme je le disais précédemment, les CPUs Intel 9 consomment significativement plus en charge, mais leur chaleur est bien mieux répartie sur la puce CPU. Ce qui fait que les Ryzen 3 ont des performances thermiques similaires.

Mais au moins c'est une plateforme moderne qui innove. On peut pas tout avoir, hein.

Auto-OC, PB2, PBO, NL2, ZGEG, ...

Un inconvénient des Ryzen 3 c'est qu'ils s'overclockent pas très bien.

C'est possible de faire un OC même fréquence sur tous les coeurs (dit OC manuel pour les fins connaisseurs) qui devrait générer un bénéfice pour tout ce qui est bench multi-coeur. Par contre en mono-coeur (et surtout en jeu) on a une perte de performances, parce que le boost normal des Ryzen 3 permet d'obtenir de plus hautes fréquences lorsque peu de coeurs sont actifs.

Ce que j'appelle le "boost normal" s'appelle normalement PB2 pour Precision Boost et euh... J'imagine que c'est le deuxième bruit*de*prout.

Comme je l'ai déjà expliqué plus haut, PB2 est une mécanique particulièrement complexe régulée par plusieurs indicateurs relevés en permanence sur le CPU par un régulateur intégré.

Le courant CPU et la puissance en pic sont limités à des valeurs bien définies. Activer PBO (Precision Boost Overdrive) désactive ou augmente ces limites. C'est tout. PBO n'améliore pas vraiment les capacités de boost ni les performance et j'avoue que c'est un peu perturbant parce que le nom laisse entendre que les performances vont augmenter.

Pour (éventuellement si on a de la chance) gagner en perfs il faut aussi activer l'Auto-OC, en plus de PBO, qui est en théorie supposé ajouter 200 Mhz à la fréquence d'horloge max de boost à un moment donné.

En pratique, parfois ça change rien du tout. Je pense qu'en général ça change rien du tout, parce que les limites de courant et puissance ne sont pas les seules limites, la capacité thermique est aussi rapidement atteinte.

Je le dis comme ça en ayant pas essayé, pour moi le ratio compliquage-de-vie par rapport aux gains est trop mauvais pour se lancer là dedans maintenant. Peut-être dans 5 ans.

Le point positif de toute cette histoire c'est que les Ryzen 3 ont l'air plutôt bien protégés contre la surchauffe avec l'étroitesse de leur circuiterie de contrôle (attention: en OC manuel je ne suis pas certain que ces protections restent d'actualité).

Et l'autre point positif mais un peu amer, c'est que le boost automatique de base des Ryzen 3 exploite déjà le silicone pratiquement au maximum et est censé même tenir compte des capacités spécifiques de votre CPU qui pourraient être supérieures ou inférieures à la moyenne.

Le PUR CHIPOTAGE MANUEL

Normalement l'OC manuel consiste à fixer pour tous les coeurs en une fois (peut aussi être opéré dans le BIOS en changeant le multiplicateur de manière statique).

Il est aussi possible de configurer les fréquences par groupe de coeurs et ça peut être intéressant.

En effet, sur les 3900x, qui présente deux chiplets 7nm de 6 coeurs, il y a toujours un "bon" chiplet (capable de booster à 4.6 Ghz) et un "mauvais" chiplet.

Normalement, le meilleur est toujours le premier. Mais c'est toujours mieux de vérifier.

L'odonnanceur de processus de Windows est censé avoir une logique de préférence pour les coeurs qui ont le potentiel de boost le plus élevé. Me demandez pas comment c'est possible... Moi qui croyais qu'un ordonnanceur ça devait être du code le plus simple possible.

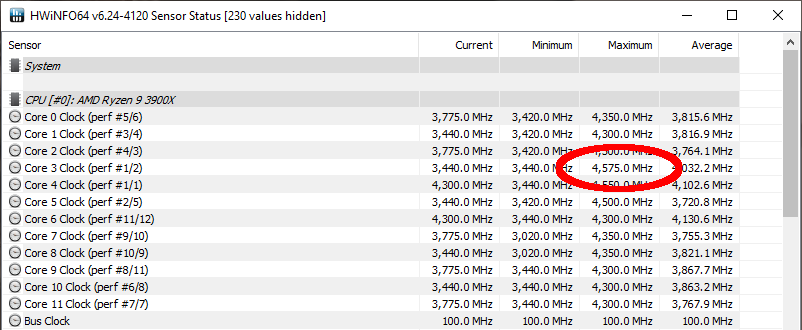

Pour trouver quel est votre "bon" chiplet il suffit de laisser trainer HWinfo64 et puis passer 30 minutes à perdre foi en l'humanité sur Twitter, puis regarder les fréquences max qui ont été observées.

Si vous êtes dans le même cas que moi, il devrait apparaitre que les 6 premiers coeurs ont les fréquences max les plus élevées: le premier chiplet est donc le meilleur.

Chaque chiplet (dit aussi CCD) est constitué de groupes de coeurs (par 3 pour le 3900x) qui s'appellent CCX.

Tant que vous y êtes vous pouvez tenter d'identifier quel CCX est le meilleur de tout le processeur.

La prochaine étape consiste à télécharger un outil AMD, Ryzen Master.

Je dois vous prévenir que le truc est légèrement artisanal.

Une fois Ryzen Master lancé, cliquez sur "Profile 2" histoire de stocker notre config quelque part.

Cliquez sur "Manual" dans la section "Control Mode" qui apparaît en haut (il s'agit d'un OC manuel, je rappel).

Placez le voltage à 1.3V. Les Ryzen 3 peuvent fonctionner à 1.35V mais le max normal en charge est 1.3V donc autant commencer là.

Vous pouvez activer les contrôles mémoire pour aussi OC votre RAM. Perso j'ai de la mémoire de merde donc je vais pas le tenter. Si vous avez ces populaires barettes Trident-Z vous pouvez probablement en tirer davantage.

Ensuite, l'idée générale est de modifier la fréquence des coeurs par CCX (même fréquence par CCX) et baisser la dite fréquence sur les CCX qui sont plus faibles. Chez moi le second CCD est clairement inférieur.

Il convient de préciser que le but de ce chipotage est d'obtenir de meilleurs performances single-thread et donc possiblement de meilleures performances dans la plupart des jeux.

Pour avoir les meilleurs performances multithread le mieux est d'opérer un OC manuel identique sur tous les coeurs (par ex. 4100 Ghz partout), alors que pour avoir les meilleurs performances mono-thread il faudrait en théorie laisser le boost à 4.6 Ghz opérer, OU BIEN, tenter d'OC un groupe de 3 coeurs le plus haut possible en ruinant les autres exprès.

C'est pour ça que c'est du chipotage, on est en train de dénaturer uun aspect important du 3900x qui est qu'il a 12 coeurs hyperthreadés et on le transforme en machin qui a beaucoup moins de coeurs ou bien qui en a trois biens et 9 pourris.

De plus, tester avec un Cinebench mono-thread ou un CPU-Z ça ne va peut-être pas révéler un gain potentiel en jeu. Pour bien faire il faudrait avoir un benchmark prêt de type CS-GO par exemple et utiliser ça comme référence.

Vous pouvez toujours commencer par tester un profil de ce type:

Testez d'abord si cette config est stable après 2-3 minutes de Cinebench R20 (ou Prime95 si vous êtes de cette fibre-là) et surveillez vos températures.

Si ça le fait, vous pouvez peut-être encore sélectivement augmenter un des CCX.

Si ça le fait pas, on peut encore engager un autre niveau de chipotage:

- Désactiver SMT (l'hyperthreading) — L'option est en dessous des fréquences dans Ryzen Master — Vous pouvez gagner un peu de température comme ça au prix de BEAUCOUP de threads en moins

- Désactiver entièrement des coeurs voire tout un CCX

- Enormément baisser la fréquence d'un des CCD

Tout en sachant que ces chipotages ne vont peut-être vous apporter aucun gain ou même réduire vos performances par rapport au mode PB2/Stock.

En pratique tout ça ne rapporte potentiellement que quelques FPS, moins si vous avez une carte graphique qui n'est pas le top du top.

Par contre c'est peut-être un bon moyen d'avoir un meilleur score super Pi. Peut-être?

Je vais pas vous faire tout un guide mais un overclock peut être instable parce que la différence entre aucune charge et pleine charge crée une chute de voltage qui rend tout instable. Vous devez alors tripoter le LLC dans le BIOS (Load Line Calibration) mais ça c'est une autre histoire.

Essayez de le garder le plus bas possible si vous devez l'augmenter.

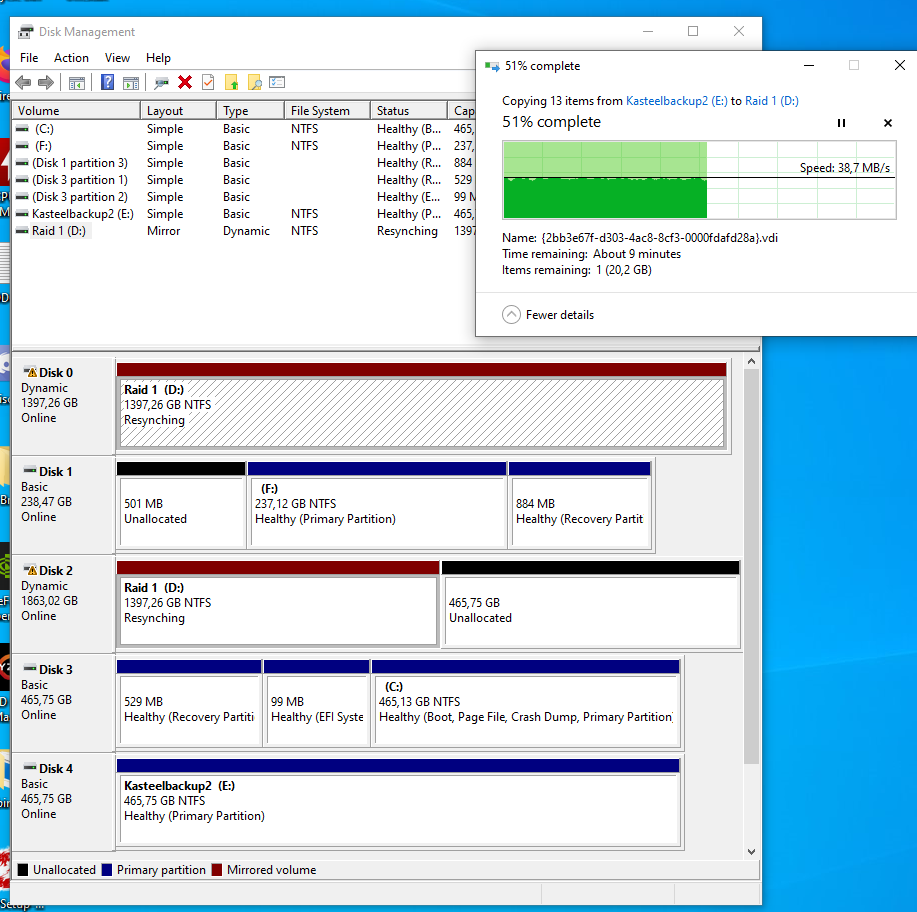

Bonus: mon bon vieux RAID 1

NB: Il s'est avéré que le type de RAID dont je parle ci-dessous (les disques dynamiques) est en fait déprécié et risque d'être viré de Windows un jour - Je parle de son remplacement dans une brève.

J'utilisais un RAID 1 de deux disques de 1.5TB sur l'ancienne machine, via la création de RAID sur la carte mère avec le contrôleur Intel RapidStorage. Qui est tout sauf rapide.

Mes vitesses d'écritures saturaient à 100% d'utilisation quelque part autour de 2 MB/s parfois. Vous y croyez ça?

C'est les mêmes performances qu'un disque dur d'ordinateur portable.

Cette fois-ci, me suis-je dit, je vais laisser le SATA en mode AHCI, et créer un RAID avec Windows, où, comme pour les RAID Linux, on peut les créer à partir de partitions et pas de disques durs complets.

Ce qui m'arrange encore davantage parce qu'un des deux 1.5TB a dû être remplacé et a une taille de 2TB, donc j'avais 500GB de gaspillés avant.

Déjà en vitesse d'écriture depuis un disque dur USB j'atteint le max de l'USB dans ce cas particulier (~40 MB/s).

C'est nettement mieux que ce que j'avais avant. En pratique la vitesse d'écriture dépasse les 70 MB/s et la lecture les 150 MB/s. A vrai dire je n'étais pas au courant que c'était possible sur un disque dur.

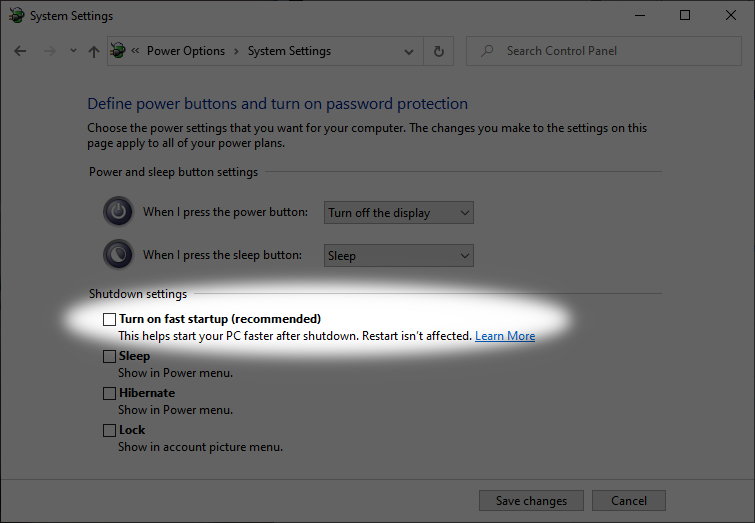

Bon, c'était pas que du bonheur non plus, parce qu'en fait j'ai remarqué que le "resyncing" recommençait à chaque démarrage, et il est super long parce que j'ai plus de 600 GB de données.

Après investigation il ressort qu'un resync est demandé quand l'arrêt de l'ordinateur ne s'est pas fait proprement. Mais attendez... J'éteins normalement et tout a l'air normal et il n'y a pas d'erreurs.

Pourtant effectivement, dans le journal d'évènement il y a un message du genre "VERY DIRTY SHUTDOWN DETECTED" (me souviens plus du message exact) et donc le RAID resync.

Des gens suggèrent de désactiver ce bon vieux "Fast startup" pour corriger le problème. Effectivement... Mon startup est légèrement moins fast mais il n'y a plus le problème.

J'ignore quelle est la cause, peut-être des options que j'ai tripotées dans le BIOS pour essayer que mes ports USB soient inactifs quand la machine est éteinte (ce que je n'ai par ailleurs jamais réussi à faire) — Ou alors c'est la faute d'Asus.

Par défaut je vais plutôt partir là dessus.

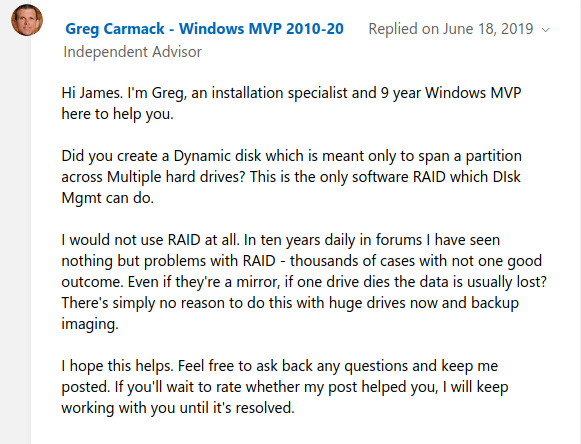

En bref là ça a l'air génial mais je sais pas trop ce qu'il se passe si un disque dur ne répond plus, j'ai lu un témoignage inquiétant sur un forum d'un Microsoft MVP:

Je ferai des tests avec une machine virtuelle et vous tiendrai au courant.

D'ici là, il est temps de s'amuser en 144 FPS.

Commentaires

Il faut JavaScript activé pour écrire des commentaires ici

#1

#2

#3